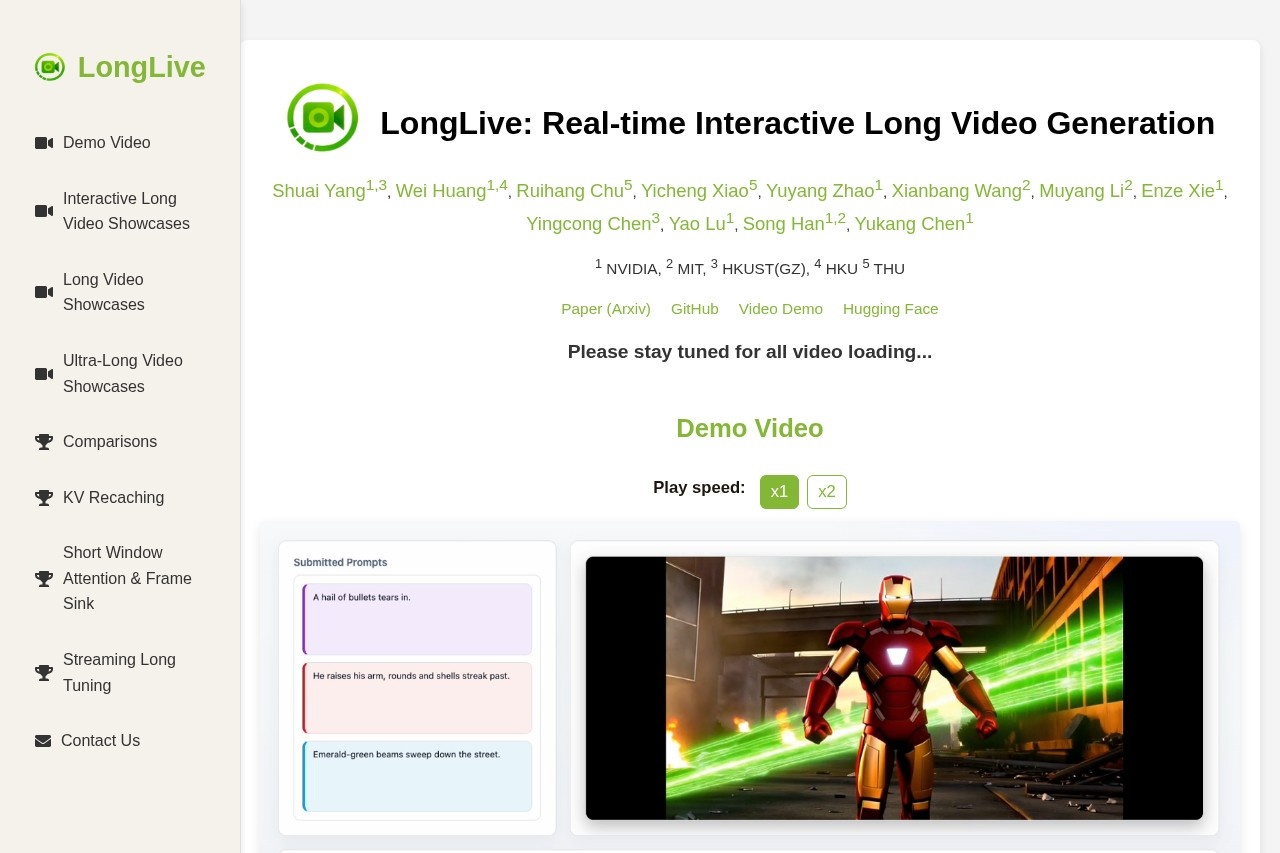

LongCat-Video 是美团“长猫团队”推出的 13.6B 参数基础视频生成模型,支持文本生成视频(Text-to-Video)、图像生成视频(Image-to-Video)和视频续写(Video Continuation)三大任务。该模型原生支持分钟级长视频生成,且在生成过程中无色彩漂移或画质下降问题。其采用粗到精(coarse-to-fine)的时空生成策略和块稀疏注意力机制,兼顾生成质量与推理效率,适用于对长视频生成有高要求的研究者与开发者。

LongCat-Video

简介:

LongCat-Video 是美团“长猫团队”推出的 13.6B 参数基础视频生成模型,支持文本生成视频(Text-to-Video)、图像生成视频(Image-to-Video)和视频续写(Video Continuation)三大任务。该模型原生支持分钟级长视频生成,且在生成过程中无色彩漂移或画质下降问题。其采用粗到精(coarse-to-fine)的时空生成策略和块稀疏注意力机制,兼顾生成质量与推理效率,适用于对长视频生成有高要求的研究者与开发者。

亮点:

- 行业领先的原生长视频生成能力,支持720p/30fps视频分钟级输出,无质量衰减

- 统一架构支持多模态视频生成任务,单一模型覆盖三大主流视频生成场景

- 采用多奖励强化学习(GRPO)优化,综合性能媲美主流开源与商业模型

主要功能:

LongCat-Video 提供开箱即用的多任务视频生成能力,支持本地部署与GPU加速推理。

- 文本生成视频:输入自然语言描述,生成高质量动态视频

- 图像生成视频:基于单张图像生成连贯动态内容,保留原始图像细节

- 视频续写:对已有视频进行时序延展,保持风格与动作一致性

- 长视频生成:原生支持生成时长数分钟的连续视频,适用于叙事类内容创作

适用场景:

- 短视频/AIGC内容创作与自动化生产

- 游戏、影视、广告行业的动态素材生成与预演

推荐理由:

LongCat-Video 代表了当前开源视频生成模型在长视频能力上的重要突破,其统一架构大幅降低多任务部署成本。模型采用MIT许可证,对学术与商业应用友好,适合希望快速集成高质量视频生成能力的团队。随着AIGC向“世界模型”演进,LongCat-Video 的长时序建模能力契合未来内容生成的核心趋势,为开发者提供前瞻性技术储备。